- The Pioneer 1833

Youtuben eduki berria gomendatzeko, testuak itzultzeko, eguraldia iragartzeko, ibilgailu autonomoak bakarrik gida daitezen, industrian pieza bat noiz hautsiko den aurreikusteko edota azkenaldian, ChatGPT-ren agerpenarekin, ia edozein testu sortzeko eta ia edozein galdera erantzuteko erabiltzen da Adimen Artifiziala (AA). Hori dena egiteko behintzat balio du, baina zer da Adimen Artifiziala? Adimen Artifizialak sortutako liluraren ondorioz, gehiegitan zentzu tekniko hutsean hausnartzen da, zer egin dezakeen galdetuz, zer den, nola funtzionatzen duen… Gutxitan aurkitzen dugu, baina, gaur egungo gizartean betetzen duen funtzioaren gaineko hausnarketarik. Alde batetik, makina makina delako, baina hori teknikoki azken milimetroraino aztertuta ere ez genukeelako kapitalismoan betetzen duen funtzioaren arrastorik izango. Artikulu honetan galdera horiei eta beste batzuei ere erantzuten saiatuko naiz, zentzu teknikoenetik eta filosofikoenetik pixka bat aldendu, eta Adimen Artifizialak gure gaur egungo sisteman betetzen duen funtzioan zentratuz, hau da, automatizazioan.

Gutxitan aurkitzen dugu gaur egungo gizartean [Adimen Artifizialak] betetzen duen funtzioaren gaineko hausnarketarik. Alde batetik, makina makina delako, baina hori teknikoki azken milimetroraino aztertuta ere ez genukeelako kapitalismoan betetzen duen funtzioaren arrastorik izango

ATZERA BEGIRA

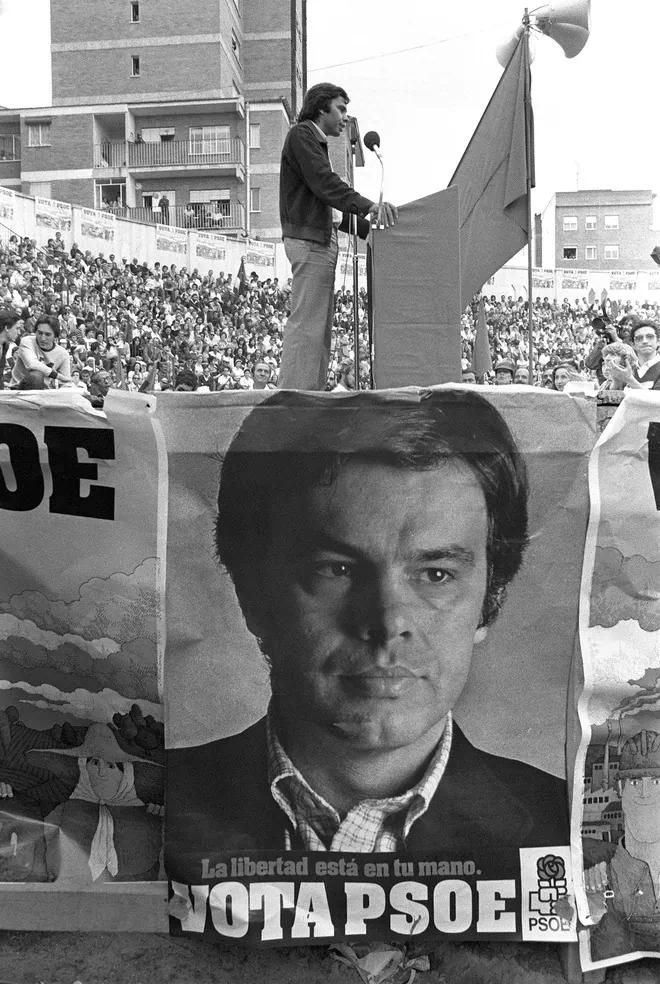

Adimen Artifiziala automatizaziorako oso tresna garrantzitsua da, eta bere hastapenetatik egon da Kapitalarekin eta Estatuarekin lotuta. Bigarren Mundu Gerraren ostean egin zuen bere lehen agerpena, garapen industrialerako lehen automatizazio-teknologiekin batera, antolatutako industria-langileen aurka egiteko. 1960ko hamarkadan, esperotako emaitzarik eman ez zuenez, ordura arteko inbertsioa asko murriztu zen, eta AAren “negua” izenekoa heldu zen. 1970-1980 artean etorri ziren sistema adituak, eta hainbat alorretako langile kualifikatuen jakintza elkarrizketa luzeen bidez jasotzeko eta automatizatzeko balio izan zuten. Orduko ikerlariek ere zuzenean lan-prozesuen automatizazioarekin lotu zituzten sistema horiek, apaingarri askorik gehitu gabe [1]. Sistema horiek oso lan zehatzetarako balio zuten, alor jakin batean erabiltzeko, eta ez ziren egoera ezberdinetara moldatzeko errazak. Muga horiek gainditzeko hainbat ikerketa egiten hasi ziren, sistema orokorragoak eta moldagarriagoak lortzeko, hots, Adimen Artifizial Orokorra (AGI, Artificial General Intelligence) erdiesteko. Azken hori ez zen posible izan; hala ere, sistema adituek industrian izan zuten eraginaren ondorioz, AArekin lotutako lehen ikasketak agertzen hasi ziren, industrian zegoen jakintza-hutsune hori betetzeko asmoz [2].

GAUR EGUN

Gaur egunera etorrita, Adimen Artifizialari buruz hitz egiteak Ikasketa Automatikoari (IA) buruz hitz egitea esan nahi du, zehatzago, Ikasketa Sakonari (Deep Learning) buruz. Artikulu honetan zehar Adimen Artifizialari buruz ariko garenetan, gehien-gehienetan azken horri buruz arituko gara. Ikasketa automatikoaren helburua datuetatik patroiak ateratzea da, eta ateratako patroi horietatik eredua deitzen zaion algoritmo bat lortzea. Problema bat ebazteko eman beharreko urratsen deskribapena da algoritmoa, soluzio hori automatizatu nahi bada ezinbestean behar dena. Batzuetan, ez daukagu algoritmorik, ez dakigu zein den problema ebazteko modua, baina baditugu problemarekin lotutako informazioa edo datuak. Kasu horretan, IA erabiliz zuzenean lor dezakegu datu horien atzean ezkutatzen den algoritmoa edo logika (horri entrenatzea deitzen zaio), eta behin eredu hori lortuta, datu berrien soluzioa eskuratzeko ere erabil daiteke. Hobeto ulertzeko adibide baten bidez ilustratu genezake: tumore bat onbera edo gaiztoa den identifikatzeko sistema bat jarri nahi dugu martxan, irudi bat hartu eta tumorea sailkatzeko gai izango dena. Aurrez, eskuz diagnostikatu diren milaka tumoreren argazkiak beharko ditugu horretarako, bai irudia, baita horietako bakoitza onbera/gaiztoa den esaten duen adierazlea ere. Horrela, sailkatzeko aurretik medikuek erabili duten logikaren berririk izan gabe, alde bateko zein besteko kasuetatik patroiak aterako dira, eta etorkizunean beste kasu bat datorrenean iraganeko kasuetatik ateratako jakintza hori erabili ahal izango da iragarpena egiteko orduan.

Garbi izan beharko genuke, beraz, datuetan oinarritzen dela Adimen Artifiziala, daturik gabe ez dela ezer, eta, hortaz, gaian adituek iraganean egindako lan horretan oinarritzen dela. Horrez gain, ikasketa automatikoa bera automatizatzeko saiakerak ere badaude: Auto ML edota Auto Labelling direlakoak dira horren adibide [3][4].

Garbi izan beharko genuke, beraz, datuetan oinarritzen dela Adimen Artifiziala, daturik gabe ez dela ezer, eta, hortaz, gaian adituek iraganean egindako lan horretan oinarritzen dela

Azken urteotako berrikuntzek geroz eta lan konplexuagoak egiteko gaitu dute Adimen Artifiziala, baina lan konplexu horiek datu askoz ere gehiagoren eta konputagailu gero eta indartsuagoen beharra dute, eta, ondorioz, horretarako aukera ia soilik teknologia-enpresa erraldoiek dute.

DATU GOSEA

Konputazio beharraren gorakada datu kopuruaren gorakadarekin batera ulertu behar da, konplexutasun handiko sistema lortu nahi bada asko handitzen baita behar den datu kopurua ere. Horren garrantziaren erakusle izan dira azkenaldian hain modan dauden hizkuntza eredu handiak (ChatGPT, Bard eta enparauak). Eredu horiek entrenatzeko ezinbestekoak izan dira milaka eta milaka testu gigabyte, kalitatezkoak. Datu multzo horiek nolakoak diren ulertzeko, CommonCrawl erabil daiteke erreferentzia gisa, zeinak milioika giga datu gordetzen duen 2008tik gutxi gorabehera Interneteko web-orrialde gehienen kopiak eginez. Hor sartzen dira milioika liburu, milioika kode-lerro, milaka artikulu zientifiko zein Wikipediako orrialde. Datu kopuruak, baina, ez du dena esaten; kalitateak du hor garrantziarik handiena. Gauzak horrela, CommonCrawl-en datuetan oinarritu eta filtro prozesu baten ostean kalitate handiagoko zenbait datu multzo sortu dira: C4, Red Pajama Datav2, edota The Pile [5-7].

Ereduak sortzeko orduan datuek duten garrantziaz jakitun, datuak biltzeko plataformak jarri dituzte martxan enpresa teknologiko erraldoiek, edota aurretik helburu hori ez zuten sare sozialak horretara bideratu dituzte. Meta taldea Instagramen, Facebooken eta Whatsappen jabea da, besteak beste. Googlek, bilatzaileaz harago, Drive, Maps, Chrome, Youtube, Android, Gmail, Meet, Translate edota Classroom plataformak garatu ditu, horietako asko guztiz doakoak. Azkenaldian, gainera, kodea automatikoki sortzeko gaitasunean atzean gelditzen ari zenez, Google IDX sortu du, online kodea editatzeko plataforma bat, non adimen artifizialeko ereduak hobetzeko aukera emango dioten milioika kode-lerrotara sarbidea izango duen. Datuek ematen diete, hortaz, enpresa horiei kalitate bereizgarri hori, eta beraien plataformetatik ateratako informazioa ezinbestekoa da AA industrian dagoen lehian aurrea hartu ahal izateko. Bereziki deigarria eta kezkagarria da zentzu horretan eskoletan, publikoetan zein itunpekoetan, nagusitu den joera: doako zerbitzuen gozokia ahora eramaten ari diren bitartean, Googleren Chromebook, Drive eta Classroom bihurtu dira ikasleen eguneroko ogi, eta datu horien jabe da orain Google [8].

Baina ez dago zertan plataforma horietara jo datu sorkuntzari buruz hitz egiteko, gure egunerokoa datu-bilketa erraldoi bihurtzen ari baitira azkenaldian: mugikorraren posizioarekin, sare sozialen erabilerarekin, errepideetako kontrolarekin (kameren bidez, bidesarien bidez, TAO makinen bidez), edota gero eta sarriago kaleetan ikusten ditugun kamerekin. Hori dena ez da kasualitatea; datu-bilketak bijilantzia dakar, eta etekinak datu-bilketa duenean ardatz, Kapitalak bijilantzia behar du. AA eta bijilantzia, hortaz, eskutik doaz.

[...] gure egunerokoa datu-bilketa erraldoi bihurtzen ari baitira azkenaldian: mugikorraren posizioarekin, sare sozialen erabilerarekin, errepideetako kontrolarekin (kameren bidez, bidesarien bidez, TAO makinen bidez), edota gero eta sarriago kaleetan ikusten ditugun kamerekin

KONPUTAZIO GAITASUNA

Adimen Artifizialaren gaitasunen gorakada, beraz, datu horiek irensteko eta horietatik ikasteko gaitasunean kokatu behar da. Beharrezko datu kopuruak gora egiteak, era berean, behar den konputazio-indarra handitzea eragiten du, eta horrekin batera entrenamendu-kostuak handitzea. Konputazio gaitasun hori handitzeak segundoko ahalik eta operazio gehien egitea esan nahi du, eta, AAren produkzioan, gaitasun horren hobekuntza Grafikoak Prozesatzeko Unitateen (GPU) erabileraren eskutik etorri da. Jokoetarako erabili ohi diren prozesagailu horiek milioika operazio matrizial egiteko aukera ireki dute 2012an lehenengoz entrenamendurako erabili zirenetik [9].

Lan konplexuagotarako eredu hobeak eraikitzeak datu gehiago ustiatu beharra eskatzen du, eta horrek, aldi berean, GPU gehiago eta indartsuagoak erabili beharra. Mundu mailako eredurik sortzerik ez dago, horretarako konputazio gaitasunik gabe, eta gaur egun horrek milioika euroko kostua du. Urtetik urtera, gainera, handituz doaz behar den GPU kopurua eta horien gaitasuna; hori dela eta, punta-puntako ereduak sortzeak behin eta berriz inbertsio handiak egitea eskatzen du. Hori egiteko gaitasuna teknologia-enpresa erraldoiek soilik dutenez, baliabide horiek errentan jartzen dizkiete haiek enpresa txikiagoei edota ikerketa taldeei, beren hodeiko plataformen bidez. Zentzu horretan, Adimen Artifizialeko ereduak sortzen dituzten enpresa zein ikerketa-zentro gehienek menpekotasun zuzena dute plataforma horiekiko, eta ondorioz, plataforma horien jabe diren enpresekiko.

NVIDIA, Intel eta AMD dira GPUen merkatuko aktorerik garrantzitsuenak; hala ere, merkatuaren %70 NVIDIAren esku dagoela kalkulatzen da [10]. NVIDIAk laukoiztu egin ditu bere etekinak azken bi urteotan, eta burtsako bere kotizazioa %200 baino gehiago igo da 2023an. Eredurik sinpleenetik hasi eta ChatGPT edo DALL.E bezalako eredu konplexuetaraino, guztiak entrenatzen dira NVIDIAren GPUekin. Eredurik sinpleenetan nahikoa izan ohi da GPU batekin; besteetan, berriz, GPU indartsuenetakoak beharko dira, milaka. GPT-4ren (ChatGPT-ren bertsio berritua) entrenamendurako, 25.000 NVIDIA A100 erabili ziren [11] 90-100 egunez. Entrenamendu horren dimentsioaz jabetzeko: merkatuko onenak diren GPU horietako bakoitzak 20.000 dolar inguru balio du, horiek 100 egunez martxan izateak duen gastu elektrikoa izugarria da, eta inpaktu ekologiko ikaragarria du [12].

Amaitzeko, bi aktore oso garrantzitsu falta dira, industria horren kapital-kontzentrazioaren erakusle direnak. Alde batetik, TSCM (Taiwan Semiconductor Manufacturing Co Ltd), NVIDIAren txip guztien produkzioaz arduratzen den enpresa. NVIDIAren gisako enpresek GPUen txipak diseinatu soilik egiten dituzte, eta prozesuak daukan konplexutasunaren ondorioz, TSCMk produzitzen ditu. Munduko txip aurreratu gehienak bertan egiten direnez, enpresa horiek guztiek TSCMrekiko garatu duten menpekotasuna handia da oso [13]. Bestetik, ASML enpresa nederlandarra daukagu, maila bat beherago prozesuan. Litografia makinak produzitzen ditu horrek, eta teknologia horri esker da gai TSCM hain txip txikiak eta modernoak ekoizteko. ASML Europa osoko enpresa teknologikorik garrantzitsuena dela esan daiteke [14], munduan bakarra den teknologia bat garatzera heldu delako mikrotxipen produkziorako. Horrek erakusten du kate horrek enpresa bakar batekiko duen menpekotasuna, eta horrek etorkizunari begira izan dezakeen eragina. Gainera, Adimen Artifizialaren oinarri fisikoa eta materiala mahai gainean jartzeko aukera ematen digu.

ADIMEN ARTIFIZIALAREN INDUSTRIA

Arlo fisikoenari heldu ostean, Adimen Artifizialaren industriaren azterketa osatu bat egitea dagokigu, parte-hartzaile bakoitzaren funtzioa identifikatzeko eta beren arteko loturak argitzeko. Industria horren barruan, hainbat motatako parte-hartzaileak identifika daitezke: teknologia erraldoiak, startup-ak edo think tank delakoak, besteak beste. Estatuek ere badute beren tokia industriaren barruan, baina horri geroago helduko diogu, nazioarteko egoeraren azterketa txiki baten bidez.

Hasteko, teknologia-enpresa erraldoiak ditugu, denok ezagutzen ditugunak: Google, Microsoft, Amazon, Meta… Teknologia-enpresa erraldoien funtzioari dagokionez, esan daiteke AAan oinarritutako bi salgai mota sortzen dituztela: alde batetik, kontsumora bideratutakoak, eta, bestetik, beste enpresa batzuen kapital finko bihurtuko direnak. Azken horren erakusle da hodeiko plataformek izan duten gorakada (Amazon Web Services, Microsoft Azure, Google Cloud Platform edota Alibaba Cloud, garrantzitsuenak aipatze aldera). AAri buruzko ikerketa bat egiteko behar den konputazio-indarra gero eta handiagoa denez, enpresa gehienentzat ezinezkoa da hardware hori jabetzan izatea, eta, horren ordez, hornitzaile horiei hartzen diete errentan. Bestalde, mota horretako enpresek startup-ik erakargarrienak erosten dituzte. Horren adibide da Googlek, 2010etik 2023 urtera, 21 AA startup erosi izana. Horien artean ezagunena Deepmind da, 500 miloi dolarretik gorako inbertsio bidez erosi zuena 2014an [15].

Startup-ei dagokienez, esan daiteke horiek sortzeko joera handia dagoela Adimen Artifizialaren bueltan, oro har, arrisku-kapitalaren inbertsiopean. Startup horien kopurua oso aldakorra da, horietako askok porrot egiten dutelako, eta beste batzuk konpainia handi horiek erosten dituztelako, izan beraien produktuetatik onura ateratzeko, izan lehia merkatutik ezabatzeko. Gainera, erosten ez diren startup horietako gehienak, azpiegitura aldetik lotuta daude jada teknologia-enpresa erraldoi horiei, euren teknologia edota zerbitzuak erabiltzen dituztelako. Argi dago funtzio nagusia betetzen dutela industriaren barruan, berrikuntza kapitalistarena, soilik (etekina sortzeko) balio duten horiek biziraungo baitute.

Think tank edo azterketa-kabineteak ikerketa-instituzio pribatuak dira; akademiak, gobernuek zein industriak finantzatuak gehienak. Esaterako, Google moduko enpresek irudia asko zaintzen dute, eta horrelako instituzioetako partaide izan ohi dira. Gizartean AAk izan ditzakeen ondorioak aztertzen dituztela esaten dute, baina, gehienetan, euren irudia zuritzeko balio izaten dute: industria belikoarekin daukaten lotura edota periferiako lurraldeetan egindakoa ezkutatu eta gizakiaren garapenaren eramaile moduan aurkezten dute, horrela, euren burua.

NAZIOARTEKO LEHIA

Esan bezala, estatuek ere oso zeregin garrantzitsua betetzen dute industria horretan. Ameriketako Estatu Batuak izan dira, duela gutxira arte, gai horren inguruan aginte-makila eraman dutenak, bertan baitago Silicon Valley entzutetsua eta bertakoak baitira teknologia-enpresa erraldoi asko. Azken urteotan baina, egoera guztiz aldatzen ari da. Munduko edozein superpotentziarentzat arlo estrategiko bat da Adimen Artifiziala, eta borroka horretan murgilduta daude, batez ere, Estatu Batuak eta Txina. Garrantzia du alor militarrean, ekonomikoan, osasungintzan, eta, batez ere, garrantzia du norbera erreferente gisa aurkezteko beste herrialdeen aurrean, azkarrenak ezartzen baititu, sarritan, erabilerari dagozkion estandarrak eta arauak.

Munduko edozein superpotentziarentzat arlo estrategikoa da AA, eta borroka horretan murgilduta daude, bereziki, AEB eta Txina. Garrantzia du alor militarrean, ekonomikoan, osasungintzan, eta batez ere, garrantzia du norbera erreferente gisa aurkezteko beste herrialdeen aurrean, azkarrenak ezartzen baititu, sarritan, erabilerari dagozkion estandarrak eta arauak

Txinaren kasuan, 2017an aurkeztu zuen Adimen Artifizialerako Garapen Plana, 2030erako Txina AA industriako lider bihurtzea helburutzat duena. Ikerketan, artikulu zientifiko aipatuenetan eta patenteetan lehena da, eta gero eta erreferente handiagoa bihurtzen ari da ikerlarientzat. Horrez gain, kontuan izan behar da munduko gainerako herrialde guztietakoak batuta baino robot gehiago dagoela Txinan, 2021az geroztik roboten instalazioa munduan %31 hazi den honetan, apustua zentzu akademiko hutsean egin ez duen seinale.

AEBetan, 2018an, 2.000 milioi dolar bideratu ziren Adimen Artifizialaren ikerketara. 2018tik 2023ra, berriz, AAren ikerketarako eta garapenerako aurrekontua % 228 igo da, 560 milioitik 1.800 milioira [16], eta defentsarako AAren ikerketarako eta garapenerako aurrekontuak % 26ko igoera izan zuen 2022tik 2023ra. Aurten, 1.100 milioi dolar bideratuko dira horretara.

Borroka hori ez dago soilik ikerketari edo garapenari lotuta. Duela gutxi Joe Biden AEBetako presidenteak herrialdeko enpresei debekatu egin die txip aurreratuak Txinari saltzea, horrela, AEBen nagusitasuna mantentzeko ahaleginean [17]. Azken hori aspalditik datorren zerbait da, eta bi herrialdeak ari dira beste herrialdeekiko daukaten menpekotasuna murriztu nahian, batez ere, erdieroaleen produkzioari dagokionez [18-22].

KODE IREKIA IZATEAREN ONURAK

Teknologia-enpresa erraldoiek asko zaindu behar izaten dute beren izen ona, gizateriaren garapena dakartela saltzen dutenez, eta azken urteotan, izen ona kode irekiko komunitatearekin ere lotu beharra dago. AArako erabiltzen diren programei eta tresnak gehien-gehienean kode irekikoak dira, hau da, tresna horiek edonork erabiltzeko moduan argitaratzen dira. Are gehiago, 2015ean Googlek TensorFlowren kodea ireki zuenetik, industriako softwarearen zatirik handiena kode irekiko bihurtzeko joera mantendu du. Konpainia handi horiek ere kode irekia jartzen diete sortzen dituzten software gehienei, jendeak erabili ahal izateko eta erabiltzaileek beren aletxoa jar dezaten tresna hobetuz. Erraldoi horietako buruek Adimen Artifiziala demokratizatzeko asmoz egiten dutela esan arren, argi dago praktika hori oso onuragarria dela eurentzat. Norbere softwarea industriako estandar bilakatzeak esan nahi du milaka pertsonak erabiliko dutela hura: jendeak inolako diru-trukerik gabe hobetuko du software hori, hau da, doako langileak arituko dira konpainia jakin baten produktuak hobetzen. Beraretzako langile potentzialak sortzeko aukera ere emango dio horrek konpainia horri, bere softwarean espezializatutako jendea izango baitu aipatutakoaren ondorioz. Gainera, komunitate horren eraginez, software horrek garrantzitsua izaten jarraituko du aldaketa azkarreko industria batean.

Horrek bigarren ondorio bat ere badu, eta Google da horren adibiderik egokiena. Azken urteotan Tensor Processing Unit (TPU) izeneko prozesadore batzuk garatu ditu, Adimen Artifizialerako bereziki sorturiko txip batzuk. Txip horiei zuku guztia atera ahal izateko, baina, Googleren softwarea erabiltzea komeni da, hau da, Googleren softwarea erabiltzeak haren txipak erabiltzera eramaten du, eta haren txipak erabiltzeak, berriz, bere softwarea erabiltzera. Hitz gutxitan, AAren merkatuan nagusitzeko estrategia gisa erabiltzen da kode irekia.

ADIMEN ARTIFIZIALA ETA LANA

Automatizazio tresna gisa, aztertu beharreko alderdi garrantzitsu bat da lana. Bi ikuspuntutatik aztertu beharko litzateke: alde batetik, AAren produkzioan lan egiten duten aktoreen banaketa eta horien lan-baldintzak, eta, bestetik, AAk automatizazio tresna gisa izan dezakeen eragina, bestetik.

AAren produkzioan lan-mota asko aurki daitezke, baina, sinplifikatze aldera, bi taldetan banatuta aurkeztuko dira testu honetan: ereduak sortzen edo kudeatzen dituzten langileak eta ereduetarako datuak prestatzen dituztenak. Lehenak dira gurean ezagunenak, teknologia-enpresetan zein unibertsitateetan behin eta berriz aipatzen direnak; datu-zientzialariak, datu-analistak, datu-ingeniariak… Oro har, ez dute funtzio zehatzik betetzen, baina helburutzat dute datu batzuetatik produktu errentagarri bat lortzea. Soldata nahiko altuak izan ohi dituzte, eskaera baino eskaintza txikiagoa dagoelako, eta oso azkar aldatzen den industria delako. Hala ere, gero aipatuko dugun moduan, erreala da lan horiek automatizatzeko aukera. Bigarren taldeari ghost worker edo langile mamu deitu izan zaie, eta eskuz egiten dute bezeroek automatikoki egiten dela uste duten lana [23]. Hain preziatuak diren datuak prestatzeko lana betetzen dute haiek, hau da, datuak garbitzea, moldatzea edo etiketatzea. Gehienetan Amazon Mechanical Turk (MTurk) bezalako plataformen bidez lan egiten dute, ordukako lanekin, inolako kontakturik gabe, eta miseriazko soldaten truke. Langile horiek egiten duten lana ezinbestekoa da industriak dirdira egin dezan. Dena hain automatikoa eta hain ederra izan dadin, milioika eskulan-

ordu guztiz prekario behar izaten dira, nahiz eta gehienak hori ezkutatzen saiatu. Horren adibide da ImageNet datu-multzo ezaguna sortzeko 49.000 langile kontratatu behar izan zituztela MTurken bidez [24], edota ChatGPT-k eduki mingarririk edo iraingarririk sor ez zezan dozenaka langile kontratatu zituztela Kenyan, Sama izeneko enpresa baten bidez. Orduko 2 dolarren truke aritu ziren langile horiek, milaka testuren artean kaltegarriak zirenak sailka zitzaten (horien artean zeuden umeen aurkako sexu-abusuei, hilketei, suizidioari edota torturari buruzko azalpen oso grafikoak) [25].

Duela gutxira arte uste zen lanik errepikakorrenak –lanik astunenak– izango zirela automatizatzen lehenak. Baina badirudi alderantziz izaten ari dela, eta badu zentzurik. Alde batetik, errepikakorra den lana eskulan merkeagoaren bidez egin ohi da, eta horrek automatizatzeko interesa murrizten du, kapitalistak ez baitu inbertsiorik egingo hartatik etekinik ateratzeko aukerarik ikusten ez badu. Bestalde, lan teknikoagoak automatizatzeko interesa badago, orokorrean soldata altuagoak baitituzte langilerik teknikoenek. Era berean, lan horiei buruzko datu asko dago Interneten, eta, beraz, asko errazten du horrek automatizazio prozesua. ChatGPT-ren egileen ikerketaren arabera, teknologia horrek aukera emango luke, besteak beste, itzultzaileen, idazleen, finantza-analisten, matematikarien edota web-orrialdeen diseinatzaileen lana automatizatzeko, baita, ironia dirudien arren, Adimen Artifizialeko ereduen sortzaileen lana ere [26].

AAk ordezkatuko dituen ohiko lanpostu horiek ekonomia globalean sortuko dituen bestelako lan prekario eta errepikakor horien biderkatzearekin batera aztertu behar dira [27][28].

Adimen Artifizialak ordezkatuko dituen ohiko lanpostu horiek ekonomia globalean sortuko dituen bestelako lan prekario eta errepikakor horien biderkatzearekin batera aztertu behar dira

ETORKIZUNARI BEGIRA: JOERAK ETA HIPOTESIAK

Ez da erraza aurrera begirako joerak asmatzea, batez ere zentzu tekniko bati begiratzen badiogu. Duela bi urte ez genukeen ChatGPT-ren potentziala usaindu ere egingo, eta, hortaz, ez gara igarle lanetan hasiko orain.

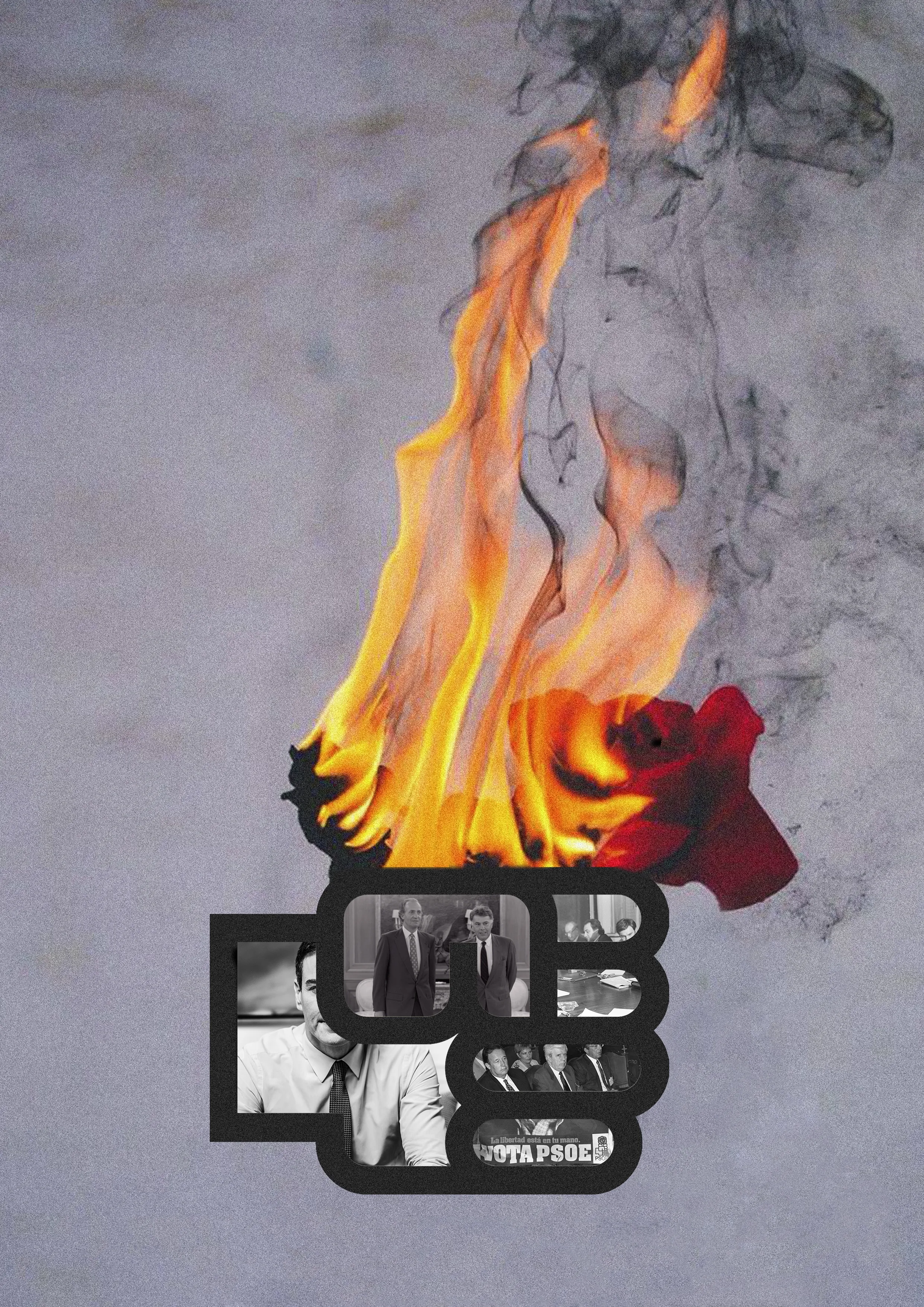

Bada, baina, Adimen Artifizialaren bueltan zer ondorioztatu. Automatizaziorako tresna gisa aztertu dugu eta hor kapitalismoaren bi joerarekin uztartuta ikusi dugu: lan teknikoen automatizazioa sustatzea eta lan mekaniko prekarioak sorraraztea. Ikusi dugu gure bizitzak datuak sortzeko mekanismo bat gehiago bihurtu direla, gure datu horien bidez, gero, intereseko iragarkiak egin diezazkiguten. Ikusi dugu eredu horien sortze-prozesuak miseria erreproduzitzen duela, MTurk-en moduko mekanismoen bitartez sektore proletarioenei lanik umiliagarrienak esleitzen baitizkie. Eta ikusi dugu ekologikoki ere jasanezina dela: gero eta eredu handiagoak sortu, orduan eta konputazio behar handiagoa dago, eta are handiagoa da inpaktu ekologikoa.

Ondorio horiek, baina, ez dira Adimen Artifizialari buruzkoak. Ez da beste modu bateko Adimen Artifizial baten aldeko eskaera bat, ezta horren garapena moteltzearen edo Estatuaren kontrola handitzearen aldekoa ere. Sistema kapitalistaren baitan kokatzen da Adimen Artifizialaren produkzio osoa, eta ezin gaitezke bestelako Adimen Artifizial baten aldekoak izan, bestelako produkzio sistema baten alde ez bagaude.

Kapitalismoaren barruan suntsipena, lan prekarioa eta miseria dakarren horrek, agian, ekar lezake bestelakorik gizarte sozialista batean. Lanaren automatizazioa denbora libre gehiago izateari begira antolatzea, eta ez etekinaren logikaren arabera. Adimen Artifizialaren potentzial osoa gizateriaren beharren menpe jartzea.

Horretarako ez da nahikoa AAren garapena gelditzea edo geldotzea [29], ez da nahikoa enpresa erraldoi horiei boikot egitea, edota gure alternatiba etikoagoak bultzatzea [30]. Beharrezkoa da, baina ez da nahikoa. Ez dago errezeta magikorik, baina gure planteamenduak osotasunetik abiatu behar dira, produkzio-modu kapitalista gainditzeko beharra hauspotzera eta indartzera bideratuta. Gaitasun teknikoak (ere) iraultza sozialistaren beharretara jarrita.

Ez dago errezeta magikorik, baina gure planteamenduak osotasunetik abiatu behar dira, produkzio-modu kapitalista gainditzeko beharra hauspotzera eta indartzera bideratuta. Gaitasun teknikoak (ere) iraultza sozialistaren beharretara jarrita

ERREFERENTZIA OROKORRAK

Artikulu hau batez ere Automation and Autonomy: Labour, Capital and Machines in the AI industry liburuan oinarritzen da. Gehiago sakontzeko The eye of the master eta Automation and the future of the work liburua gomendatzen da.

[1] E. A. Feigenbaum, P. McCorduck, eta H. Penny, The Rise of the Expert Company. 1988.

[2] A. Roland, Strategic Computing: DARPA and the Quest for Machine Intelligence, 1983-1993. 2002.

[3] Grounded-SAM Contributors, “Grounded-Segment-Anything”. 2023ko apirilaren 6a. Online: https://github.com/IDEA-Research/Grounded-Segment-Anything

[4] Roboflow, “OpenAI vision API environments”. 2023ko azaroaren 7a. Online: https://github.com/roboflow/awesome-openai-vision-api-experiment

[5] L. Gao et al., “The Pile: An 800GB Dataset of Diverse Text for Language Modeling”. arXiv, 2020ko abenduaren 31. doi: 10.48550/arXiv.2101.00027.

[6] C. Raffel et al., “Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer”. arXiv, 2023ko irailaren 19a. Data honetan kontsultatua: 2023ko azaroaren 15a. Online: http://arxiv.org/abs/1910.10683

[7] Together Computer, “RedPajama: an Open Dataset for Training Large Language Models”. 2023ko urria. Online: https://github.com/togethercomputer/RedPajama-Data

[8] U. Apaolaza, “Google eta Hezkuntza Sailaren arteko hitzarmena argitaratu du EAEko aldizkari ofizialak”. Online: https://www.argia.eus/albistea/google-eta-hezkuntza-sailaren-arteko-hitzarmena-argitaratu-du-eaeko-aldizkari-orokorrak

[9] A. Krizhevsky, I. Sutskever, eta G. E. Hinton, “ImageNet Classification with Deep Convolutional Neural Networks”, 2012.

[10] J. Ross, “Nvidia vs. AMD vs. Intel: Comparing AI Chip Sales”. Online: https://www.visualcapitalist.com/nvidia-vs-amd-vs-intel-comparing-ai-chip-sales/

[11] S. M. Walker, “Everything we know about GPT-4”. Online: https://klu.ai/blog/gpt-4-llm

[12] A. S. Luccioni, S. Viguier, eta A.-L. Ligozat, “Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model”. arXiv, 2022ko azaroaren 3a. Data honetan kontsultatua: 2023ko azaroaren 16a. Online: http://arxiv.org/abs/2211.02001

[13] The Economist, “Taiwan’s dominance of the chip industry makes it more important”. Online: https://www.economist.com/special-report/2023/03/06/taiwans-dominance-of-the-chip-industry-makes-it-more-important

[14] C. O’Grady eta M. Kenyon, “How ASML became Europe’s most valuable tech firm”. Online: https://www.bbc.com/news/business-64514573

[15] CBInsights, “The big tech company leading in AI acquisitions”. Online: https://www.cbinsights.com/research/big-tech-ai-acquisitions/

[16] “SUPPLEMENT TO THE PRESIDENT’S FY 2023 BUDGET”. Noviembre de 2022. Online: https://www.nitrd.gov/pubs/FY2023-NITRD-NAIIO-Supplement.pdf

[17] M. Toh eta K. Tausche, “US escalates tech battle by cutting China off from AI chips”. Online: https://edition.cnn.com/2023/10/18/tech/us-china-chip-export-curbs-intl-hnk/index.html

[18] J. A. Lewis, “China’s Pursuit of Semiconductor Independence”. Online: https://www.csis.org/analysis/chinas-pursuit-semiconductor-independence

[19] Q. Liu, “China’s biggest chipmaker warns geopolitics is stoking global glut”. Online: https://www.ft.com/content/30e61fb3-ac48-4ece-94fb-af0c3763d99c

[20] Reuters, “China’s semiconductor state fund invests $2 billion in memory chip firm”. Online: https://www.reuters.com/technology/chinas-semiconductor-state-fund-invests-2-billion-memory-chip-firm-2

- The Pioneer, 1833

Para recomendar nuevo contenido en Youtube, traducir textos, predecir el tiempo, para que los vehículos autónomos se conduzcan solos, prever cuándo se romperá una pieza en la industria o, últimamente, con la aparición de ChatGPT, la Inteligencia Artificial (IA) se emplea para crear prácticamente cualquier texto, o para responder a casi cualquier pregunta. Por lo menos sirve para todo eso, pero ¿qué es la Inteligencia Artificial? A raíz de la fascinación que la Inteligencia Artificial ha creado, a menudo se reflexiona en un sentido meramente técnico, se pregunta qué puede hacer, qué es, cómo funciona… No obstante, rara vez encontramos reflexión alguna acerca de la función que cumple en la sociedad actual. Por un lado, porque la máquina es máquina, pero por mucho que la analicemos hasta el último milímetro no encontraremos ni rastro de la función que cumple en el capitalismo. En este artículo trataré de encontrar respuestas a esas y a otras interrogantes, alejándome del sentido más técnico y filosófico, centrándome en la función que cumple la IA en el sistema capitalista, es decir, en la automatización.

MIRANDO ATRÁS

La IA es una herramienta de importancia decisiva para la automatización, y desde sus orígenes, ha estado íntimamente vinculado al Capital y al Estado. Hizo su primera aparición tras la Segunda Guerra Mundial, de la mano de las primeras tecnologías de automatización para el desarrollo industrial, con el objetivo de hacer frente a los trabajadores de industria organizados. En la década de 1960, al no cosechar los resultados esperados, la inversión sufrió una gran reducción, y llegó el llamado “invierno” de la IA. Entre 1970-1980 llegaron los sistemas expertos, que sirvieron para recoger y automatizar el conocimiento de trabajadores cualificados de diversos ámbitos a través de conversaciones largas [1]. Los investigadores de la época relacionaron directamente dichos sistemas a la automatización de los procesos de trabajo, sin adornarlos demasiado [1]. Estos sistemas servían para trabajos muy específicos, para ser utilizados en un ámbito específico, mientras no era tan sencillo amoldarlos a situaciones diversas. Para superar dichas limitaciones comenzaron a realizar numerosas investigaciones, con el objetivo de lograr sistemas más generales y adaptables, o dicho de otra manera, alcanzar la Inteligencia Artificial General (AGI, Artificial General Intelligence). Aunque esto no fue posible, por el impacto que los sistemas especializados tuvieron en la industria, comenzaron a aparecer los primeros estudios vinculados a la IA, con el propósito de llenar dicho vacío de conocimiento en la industria [2].

HOY EN DÍA

En la actualidad, hablar acerca de la IA significa hablar sobre el Aprendizaje Automático (AA), más concretamente sobre el Aprendizaje Profundo (Deep Learning). Cuando hablemos sobre la IA a lo largo de este artículo, estaremos, en la mayoría de los casos, hablando acerca de esto último. El objetivo del AA es sacar patrones partiendo de datos, para conseguir un algoritmo denominado “modelo” a partir de esos patrones. Un algoritmo es la descripción de los pasos que es necesario dar para solucionar un problema, algo imprescindible de querer automatizar dicha solución. En ocasiones, no tenemos ningún algoritmo, no conocemos la manera de solucionar el problema, pero si disponemos de información o datos relacionados con el problema. En esos casos, empleando la AA podemos conseguir directamente el algoritmo o lógica que se esconde tras esos datos (a este proceso se le da el nombre de entrenamiento), y, una vez hallado el modelo, también puede ser empleado para conseguir la solución para datos nuevos. Ilustrémoslo con un ejemplo para que se entienda mejor: queremos poner en marcha un sistema que identifique si un tumor es benigno o maligno, que sea capaz de coger una imagen y clasificarlo. Para ello, necesitaremos en primer lugar imágenes de miles de tumores diagnosticados manualmente, la imagen, e indicar en cada uno de los casos si es benigno/maligno. De esa manera, sin tener conocimiento de la lógica que han empleado los médicos para clasificarlos a priori, se sacarán patrones de casos de un lado y del otro, y en el futuro, cuando llegue un nuevo caso, podrá utilizarse el conocimiento alcanzado a partir de los casos pasados a la hora de hacer la predicción.

Por lo tanto, deberíamos tener claro que la IA encuentra su base en los datos, que sin datos no es nada, y que, por lo tanto, se basa en el trabajo realizado por especialistas en ese campo en el pasado. Además, también existen ensayos para la automatización del AA: el AutoML o el Auto Labelling son ejemplo de ello [3][4].

Las innovaciones de los últimos años han capacitado a la IA para realizar trabajos cada vez más complejos, pero estos trabajos complejos precisan de muchos más datos y computadoras cada vez más potentes. Por lo tanto, esta posibilidad se reserva, casi exclusivamente, a las grandes tecnológicas.

HAMBRE DE DATOS

La necesidad creciente de computación debe entenderse de la mano del crecimiento de la cantidad de datos, ya que la cantidad de datos precisados crecerá notablemente en correlación directa con el nivel de complejidad del sistema deseado. Los grandes modelos de idiomas tan de moda últimamente (ChatGPT, Bard y demás) son muestra de la importancia que esto reviste. Para el entrenamiento de estos modelos se ha precisado de miles y miles de gigabytes de textos de calidad. Para entender cómo son estos conjuntos de datos, podemos utilizar CommonCrawl a modo de referencia, el cual almacena millones de gigas de datos a través de hacer copias de la mayoría de páginas web desde 2008 aproximadamente. Aquí entran millones de libros, millones de líneas de código, miles de artículos científicos y páginas de Wikipedia. En cualquier caso, la cantidad de datos no lo dice todo; es la calidad la que importa. Así las cosas, se han ido creando algunos otros bancos de datos de mayor calidad partiendo de los datos de CommonCrawl y su filtrado: C4, Red Pijama Datav2, o The Pile [5-7].

Conocedores de la importancia de los datos a la hora de crear modelos, las grandes tecnológicas han puesto en marcha plataformas para el recabado de datos, o bien han dirigido las redes sociales a cumplir esa función, que antes no tenían. El grupo Meta es entre otras cosas dueño de Instagram, Facebook y Whatsapp. Google, además del buscador, ha desarrollado las plataformas de Drive, Maps, Chrome, Youtube, Android, Gmail, Meet, Translate o Classroom, muchas de ellas totalmente gratuitas. Son los datos los que otorgan a estas empresas el distintivo de calidad, y la información sacada de sus plataformas resulta indispensable para adquirir ventaja en la competencia existente en la industria de la IA. En ese sentido, es especialmente llamativa y preocupante la tendencia que se ha impuesto en las escuelas, sean públicas o no: mientras se meten el caramelo de los servicios gratuitos en la boca, los Chromebook, Drive y Classroom (todos ellos de Google) se han convertido en el pan de cada día para el alumnado, y sus datos han pasado a ser propiedad de Google [8].

Pero tampoco es necesario ir a dichas plataformas para hablar de la creación de datos, ya que nuestro día a día se ha convertido en un enorme recabado de datos: con la geolocalización de los móviles, la utilización de redes sociales, el control en las carreteras (a través de cámaras, peajes, máquinas de OTA) o con las cada vez más habituales cámaras en las calles. Todo esto no es casualidad; la compilación de datos acarrea vigilancia, y cuando el beneficio tiene como eje dicha compilación, el Capital necesita vigilar. Por lo tanto, la IA y la vigilancia caminan de la mano.

CAPACIDAD DE COMPUTACIÓN

En ese sentido, la capacitación creciente de la IA debe situarse en la capacidad de ingerir estos datos y aprender de ellos. El aumento en la cantidad de datos necesarios, a su vez, acarrea el aumento de la capacidad de computación necesaria, y junto a esto los costes de entrenamiento. Aumentar dicha capacidad de computación significa la capacidad de hacer una mayor cantidad de operaciones por segundo, y en la producción de IA el mejoramiento de esta capacidad ha venido de la mano del empleo de las Unidades de Procesamiento de Gráficos (GPU, Graphics Processing Unit). Estos procesadores, que se utilizan habitualmente para juegos, han abierto la posibilidad de realizar millones de operaciones matriciales por segundo desde que se utilizaron por primera vez para el entrenamiento en 2012 [9].

La elaboración de modelos mejores para la realización de trabajos más complejos precisa de una GPU explotación de datos, y esto, al mismo tiempo, precisa de la utilización de más y más potentes GPUs. No hay posibilidad de construir un modelo de categoría mundial sin la capacidad de computación para ello, y, a día de hoy, esto tiene un coste millonario. Además, año a año, la cantidad de GPU necesaria y su capacidad crecen; por ello la generación de modelos punteros exige realizar constantemente grandes inversiones. Como la capacidad de hacerlas está reservada a las empresas gigantes, estas arriendan dichos recursos a empresas o grupos de investigación de menor tamaño a través de sus plataformas de la nube. En ese sentido, la gran mayoría de empresas o centros de investigación que crean modelos de IA tienen una dependencia directa hacia dichas plataformas y, por lo tanto, hacia las empresas a las que pertenecen dichas plataformas.

Los actores principales en el mercado de GPU son NVIDIA, Intel y AMD; no obstante, se calcula que el 70%del mercado está en manos de NVIDIA [10]. NVIDIA ha cuadruplicado sus beneficios en los últimos dos años y su cotización en bolsa ha aumentado un 200%en el 2023. Todos, empezando por los modelos más simples hasta aquellos más complejos, como ChatGPT o DALL.E, se entrenan con los GPU de NVIDIA. En el caso de los modelos más simples basta con un GPU; en los casos más punteros, en cambio, harán falta miles de los más potentes. Para el entrenamiento del GPT-4 (la versión actualizada de ChatGPT) se emplearon 25.000 NVIDIA A100 [11] durante 90-100 días. Para percatarnos de la dimensión de este entrenamiento: cada una de estas GPU (que son las mejores del mercado) cuesta alrededor de 20.000 dólares, mantener en funcionamiento semejante cantidad de ellas durante 100 días supone un gasto eléctrico inmenso, y no hace falta decir cuál es su impacto ecológico [12].

Para terminar, faltan por mencionar dos actores de gran importancia, ejemplo de la concentración de Capital que se da en esta industria. Por un lado, TSCM (Taiwan Semiconductor Manufacturing Co Ltd), encargada de la producción de todos los chips de NVIDIA. Las empresas como NVIDIA se limitan a diseñar los chips de las GPU, y por la complejidad que reviste este proceso, TSCM las produce. Como la gran mayoría de chips avanzados que se producen en el mundo las hace dicha empresa, la dependencia que todas estas empresas han desarrollado hacia TSCM es inmensa [13]. Por otro lado, tenemos a la empresa neerlandesa ASML, un nivel por debajo en la cadena de dicho proceso. Esta produce máquinas de litografía, y es gracias a su tecnología que TSCM es capaz de producir chips tan pequeños y modernos. Podría decirse que ASML es la empresa tecnológica más importante de toda Europa [14], ya que ha conseguido desarrollar una tecnología única en el mundo para la producción de microchips. Esto demuestra la dependencia que esta cadena tiene hacía una única empresa, y las consecuencias que esto puede acarrear a futuro. Además, nos brinda la posibilidad de sacar a relucir la base física y material de la IA.

INDUSTRIA DE LA IA

Tras haber abordado el apartado más físico, nos toca hacer un examen completo de la industria de la IA, para identificar la función de cada uno de los participantes y aclarar los vínculos existentes entre ellos. Dentro de esta industria se pueden identificar participantes de diversa índole: gigantes de la tecnología, las startups o los think tanks, entre otros. Los estados también encuentran su lugar en la industria, pero a eso llegaremos más tarde, a través de un pequeño examen del panorama internacional.

En primer lugar nos encontramos con las grandes tecnológicas, conocidas por todos: Google, Microsoft, Amazon, Meta… En lo que respecta a su función, podría decirse que crean dos tipos de mercancías basadas en la IA: las destinadas al consumo por una parte, y las que harán las veces de capital fijo en otras empresas, por otra parte. El ascenso de las plataformas de la nube (Amazon Web Services, Microsoft Azure, Google Cloud Platform o Alibaba Cloud, por mencionar las más importantes) es una muestra de esto último. Al crecer la fuerza computacional necesaria para realizar investigaciones acerca de la IA, a la mayoría de empresas les es imposible tener dicho hardware en propiedad, y, en su lugar, se lo toman en arriendo a estos proveedores. Por otro lado, este tipo de empresas compran las startup más atractivas. Muestra de ello son las 21 startup relacionadas con la IA compradas por Google entre 2010 y 2023. Entre ellas, la más conocida es Deepmind, comprada por una inversión de más de 500 millones de dólares en 2014.

En lo concerniente a las startup, podría decirse que existe una gran tendencia a crearlas en torno a la IA, en general a través de la inversión por capital riesgo. La cantidad de startup es muy cambiante, ya que muchas de ellas fracasan, y otras son compradas por las grandes empresas ya mencionadas, bien para beneficiarse de sus productos, o bien para eliminar a la competencia del mercado. Además, la gran mayoría de las startup que no son compradas ya se hallan vinculadas a dichas empresas de gran tamaño a nivel de infraestructura, ya que dependen de su tecnología o servicios. Está claro que cumplen una función central dentro de la industria, la de la innovación capitalista: sólo aquellas que sirvan (para crear beneficio) sobrevivirán.

Los think tank o gabinetes estratégicos son instituciones privadas de investigación, academias, financiadas en su mayoría por gobiernos y empresas privadas. Por ejemplo, empresas como Google acostumbran a cuidar mucho su imagen, y a menudo participan en este tipo de instituciones. Aunque dicen analizar las consecuencias de la IA en la sociedad, lo cierto es que mayormente solo sirven para su lavado de cara: para esconder su relación con la industria bélica o sus acciones en los países de la periferia y de esa manera presentarse al mundo como los portadores del desarrollo humano.

LA COMPETENCIA INTERNACIONAL

Como ya se ha mencionado, los estados también cumplen una parte muy importante en esta industria. Los Estados Unidos de América han sido hasta hace poco los que han llevado la batuta en este ámbito, ya que allí se encuentra el célebre Silicon Valley y de allí son muchas de las grandes tecnológicas. En los últimos años, en cambio, el panorama está cambiando drásticamente. El ámbito de la IA es estratégico para cualquier superpotencia del mundo, y sobre todo Estados Unidos y China se hallan sumidos en esta lucha. Tiene importancia militar, económica y médica, y sobre todo para presentarse como referente de cara al resto de países, ya que a menudo es el más rápido el que impone los estándares y las normas para su uso.

China presentó su Plan de Desarrollo para la Inteligencia Artificial en 2017, que tiene como objetivo convertir a China en líder de la industria de la IA para 2030. En la investigación, en los artículos científicos más referenciados y patentes se encuentra ya en primer lugar, y representa una referencia cada vez mayor para los investigadores. Además de eso, debemos tener en cuenta que China cuenta con una cantidad de robots superior a la suma de la cantidad de robots del resto de países, en un momento en el que la instalación de robots a nivel mundial ha crecido un 31%desde el 2021, lo cual es señal de que su apuesta no se limita a lo estrictamente académico.

En los EE.UU. se dedicaron 2.000 millones de dólares a la investigación de la IA en 2018. Entre 2018 y 2023, sin embargo, el presupuesto para la investigación y el desarrollo de la IA ha crecido un 228%, de 560 millones a 1.800 millones [16], y el de investigación y desarrollo de la IA para defensa tuvo un 26%de incremento entre 2022 y 2023. Este año se destinarán 1.100 millones de dólares a ese fin.

Esta lucha no está relacionada únicamente con la investigación y el desarrollo. Hace poco el presidente de los EE.UU. Joe Biden prohibía a las empresas americanas vender chips avanzados a China, en un intento de mantener su superioridad [17]. Esto último es algo que viene de lejos, y los dos países están intentando disminuir su dependencia hacia otros países, sobre todo en lo que respecta a la producción de semiconductores [18-22].

LAS VENTAJAS DEL CÓDIGO ABIERTO

Las grandes tecnológicas suelen tener que cuidar mucho su buen nombre, ya que dicen traer el desarrollo de la humanidad, y en los últimos años, también hay que asociar el buen nombre con la comunidad de código abierto. En lo que respecta a los programas y herramientas que se emplean para la IA, se podría decir que en su gran mayoría son de código abierto, esto es, que estas herramientas se hacen públicas, de tal manera que cualquiera puede utilizarlas. Más aún, desde que en el 2015 Google abriese TensorFlow, se ha venido manteniendo la tendencia de abrir la mayoría del software de esta industria para que la gente pueda utilizarlos y para que estos usuarios pongan su granito de arena mejorando la herramienta. Aunque los jefes de estos gigantes digan hacer esto con el objetivo de democratizar la IA, es evidente que esta práctica les beneficia enormemente. Convertir un software propio en estándar industrial se traduce en su uso por parte de millones de personas: la gente va a mejorar ese software sin pedir ningún pago a cambio, esto es, cierta empresa dispondrá de trabajadores gratuitos mejorando sus productos. Eso también dará a esa compañía la oportunidad de crear trabajadores potenciales para ella, ya que, a raíz de lo mencionado, dispondrá de personal especializado en su software. Además, dicha comunidad respaldará la importancia de ese software en una industria increíblemente cambiante.

Esto también tiene una segunda consecuencia, y Google es el mejor ejemplo de ello. En los últimos años ha desarrollado unos procesadores denominados Tensor Processing Unit (TPU), unos chips específicamente creados para la Inteligencia Artificial. En cualquier caso, para poder exprimir al máximo estos chips, es recomendable utilizar el software de Google, esto es, utilizar el software de Google lleva a utilizar sus chips, y utilizar sus chips a utilizar su software. En pocas palabras, se emplea el código abierto como estrategia para dominar el mercado de la IA.

LA IA Y EL TRABAJO

En tanto herramienta de automatización, el trabajo es un ámbito a analizar de gran importancia. Debe ser analizado desde dos puntos de vista: la división del trabajo de los actores que trabajan en la producción de IA y sus condiciones de trabajo, por un lado, y el impacto que puede tener como herramienta de automatización, por otro.

Se puede encontrar una gran variedad de trabajos en la producción de la IA, pero por simplificar el asunto, los dividiremos en dos grupos: los trabajadores que crean o gestionan modelos y aquellas que preparan los datos para dichos modelos. Los primeros son los más conocidos entre nosotros, aquellos que se mencionan una y otra vez en las empresas tecnológicas y las universidades; científicos de datos, analistas de datos, ingenieras de datos… En general no cumplen ninguna función en específico, pero tienen como objetivo lograr un producto rentable a partir de ciertos datos. Suelen tener unos sueldos bastante altos, pues existe una mayor demanda que oferta y se trata de una industria de transformación rápida. En cualquier caso, tal y como explicaremos más tarde, existe una posibilidad real de automatizar estos trabajos. Al segundo grupo se le ha venido conociendo como el de los ghost worker o el de los trabajadores fantasma, ya que se dedican a realizar a mano aquel trabajo que el cliente piensa se hace automáticamente [23]. Estos se encargan del trabajo de preparar los tan preciados datos, esto es, limpiarlos, modificarlos o etiquetarlos. En general trabajan a través de plataformas como Amazon Mechanical Turk (MTurk), trabajan por horas, sin ningún tipo de contacto, y a cambio de salarios de miseria. El trabajo que estas trabajadoras realizan es imprescindible para que la industria brille; se precisa de millones de horas de trabajo totalmente precarias para que todo se presente de manera tan automática y bella, por mucho que la mayoría intente esconderlo. Por ejemplo, fue necesario contratar a 49.000 trabajadores a través de MTurk [24] para crear el banco de datos ImageNet, o que ChatGPT contratase a docenas de trabajadores en Kenia a través de una empresa llamada Sama, a cambio de dos dólares la hora, para que el ChatGPT no crease contenidos hirientes o insultantes, clasificando aquellas que fuesen perjudiciales (entre ellos había explicaciones muy gráficas tanto de abusos sexuales, como de asesinatos, suicidios y torturas) [25].

Hasta hace poco se pensaba que los primeros trabajos en automatizarse serían los más repetitivos, o tediosos, pero parece que ocurre al revés, y la verdad es que tiene sentido. Por una parte, el trabajo más repetitivo suele llevarse a cabo empleando mano de obra barata, lo que disminuye el interés hacia su automatización, ya que si el capitalista no ve opción de sacar beneficio, no realizará ninguna inversión. Por otra parte, sí que existe un interés por automatizar las tareas más técnicas, teniendo en cuenta que en general los trabajadores más técnicos son los que suelen recibir los sueldos más altos. A su vez, hay una gran cantidad de datos acerca de estos trabajos en Internet, y esto facilita mucho el proceso de automatización. Las investigaciones realizadas por los creadores de ChatGPT alegan que esta tecnología abriría las puertas a la automatización de los trabajos de traductoras, escritores, analistas financieros, matemáticas o diseñadores web, y también, aunque resulte irónico, el de los creadores de modelos de Inteligencia Artificial [26].

La sustitución de estos puestos de trabajo habituales por la Inteligencia Artificial debe analizarse de la mano del resto de trabajos precarios y repetitivos que se crearán en la economía global [27][28].

MIRANDO AL FUTURO: TENDENCIAS E HIPÓTESIS

No resulta sencillo adivinar las tendencias de cara al futuro, sobre todo si nos limitamos al sentido técnico. Hace dos años no hubiésemos sido capaces ni siquiera de oler el potencial de ChatGPT, y, por lo tanto, no empezaremos a hacer de adivinos ahora.

En cualquier caso, sí que hay qué concluir en el ámbito de la Inteligencia Artificial. Lo hemos examinado en términos de herramienta para la automatización y así hemos podido verlo en conjunción con dos tendencias del capitalismo: incitar la automatización de los trabajos técnicos y generar trabajos mecánicos precarios. Hemos visto que nuestras vidas se han convertido en un mecanismo más para la creación de datos para que después nos den los anuncios que nos interesen/gusten partiendo de esos datos. Hemos visto que el proceso de creación de esos modelos reproduce la miseria a través de mecanismos como MTurk, asignando los trabajos más humillantes a los sectores más proletarios. Además, hemos visto que también resulta insostenible a nivel ecológico: se crean modelos cada vez más grandes, una necesidad de computación mayor, un impacto ecológico mayor.

En cualquier caso, estas conclusiones no se reducen a la Inteligencia Artificial. No se trata de reclamar otro tipo de Inteligencia Artificial, ni siquiera de una queja que llama a frenar el progreso o a aumentar el control del Estado. La producción total de la Inteligencia Artificial se sitúa en el sistema capitalista, y no es posible apostar por otro tipo de Inteligencia Artificial diferente si no apostamos por un sistema de producción distinto.

Aquello que en el capitalismo crea destrucción, trabajo precario y miseria, podría, tal vez, crear algo distinto en una sociedad socialista. Organizar la automatización del trabajo con miras a tener más tiempo libre, no en la lógica del beneficio. Subordinar el potencial de la Inteligencia Artificial a las necesidades de la humanidad.

Para ello, no es suficiente con parar o frenar el desarrollo de la IA [29], no es suficiente con hacer boicot a esas empresas gigantes, o remar a favor de alternativas más éticas [30]. Es necesario, pero no es suficiente. No hay recetas mágicas, pero nuestros planteamientos deben partir de la totalidad, a alimentar, reforzar, la necesidad de superar el modo de producción capitalista. Subordinando (también) las capacidades técnicas a la revolución socialista.

REFERÉNCIAS GENERALES

Este artículo se ha basado especialmente en el libro Automation and Autonomy: Labour, Capital and Machines in the AI industry. En caso de querer profundizar más en el tema, se recomienda el libro The eye of the master eta Automation and the future of the work.

[1] E. A. Feigenbaum, P. McCorduck, y H. Penny, The Rise of the Expert Company. 1988.

[2] A. Roland, Strategic Computing: DARPA and the Quest for Machine Intelligence, 1983-1993. 2002.

[3] Grounded-SAM Contributors, “Grounded-Segment-Anything”. 6 de abril de 2023. [En línea]. Disponible en: https://github.com/IDEA-Research/Grounded-Segment-Anything

[4] Roboflow, “OpenAI vision API environments”. 7 de noviembre de 2023. [En línea]. Disponible en: https://github.com/roboflow/awesome-openai-vision-api-experiment

[5] L. Gao et al., “The Pile: An 800GB Dataset of Diverse Text for Language Modeling”. arXiv, 31 de diciembre de 2020. doi: 10.48550/arXiv.2101.00027.

[6] C. Raffel et al., “Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer”. arXiv, 19 de septiembre de 2023. Accedido: 15 de noviembre de 2023. [En línea]. Disponible en: http://arxiv.org/abs/1910.10683

[7] Together Computer, “RedPajama: an Open Dataset for Training Large Language Models”. octubre de 2023. [En línea]. Disponible en: https://github.com/togethercomputer/RedPajama-Data

[8] U. Apaolaza, “Google eta Hezkuntza Sailaren arteko hitzarmena argitaratu du EAEko aldizkari ofizialak”. [En línea]. Disponible en: https://www.argia.eus/albistea/google-eta-hezkuntza-sailaren-arteko-hitzarmena-argitaratu-du-eaeko-aldizkari-orokorrak

[9] A. Krizhevsky, I. Sutskever, y G. E. Hinton, “ImageNet Classification with Deep Convolutional Neural Networks”, 2012.

[10] J. Ross, “Nvidia vs. AMD vs. Intel: Comparing AI Chip Sales”. [En línea]. Disponible en: https://www.visualcapitalist.com/nvidia-vs-amd-vs-intel-comparing-ai-chip-sales/

[11] S. M. Walker, “Everything we know about GPT-4”. [En línea]. Disponible en: https://klu.ai/blog/gpt-4-llm

[12] A. S. Luccioni, S. Viguier, y A.-L. Ligozat, “Estimating the Carbon Footprint of BLOOM, a 176B Parameter Language Model”. arXiv, 3 de noviembre de 2022. Accedido: 16 de noviembre de 2023. [En línea]. Disponible en: http://arxiv.org/abs/2211.02001

[13] The Economist, “Taiwan’s dominance of the chip industry makes it more important”. [En línea]. Disponible en: https://www.economist.com/special-report/2023/03/06/taiwans-dominance-of-the-chip-industry-makes-it-more-important

[14] C. O’Grady y M. Kenyon, “How ASML became Europe’s most valuable tech firm”. [En línea]. Disponible en: https://www.bbc.com/news/business-64514573

[15] CBInsights, “The big tech company leading in AI acquisitions”. [En línea]. Disponible en: https://www.cbinsights.com/research/big-tech-ai-acquisitions/

[16] “SUPPLEMENT TO THE PRESIDENT’S FY 2023 BUDGET”. Noviembre de 2022. [En línea]. Disponible en: https://www.nitrd.gov/pubs/FY2023-NITRD-NAIIO-Supplement.pdf

[17] M. Toh y K. Tausche, “US escalates tech battle by cutting China off from AI chips”. [En línea]. Disponible en: https://edition.cnn.com/2023/10/18/tech/us-china-chip-export-curbs-intl-hnk/index.html

[18] J. A. Lewis, “China’s Pursuit of Semiconductor Independence”. [En línea]. Disponible en: https://www.csis.org/analysis/chinas-023-10-31/

[21] D. Shepardson, “US reports big interest in $52 billion semiconductor chips funding”. Online: https://www.reuters.com/technology/us-reports-big-interest-52-billion-semiconductor-chips-funding-2023-08-09

[22] S. Van Sloun, “U.S. Investment in Semiconductor Manufacturing: Building the Talent Pipeline”. Online: https://www.cfr.org/blog/us-investment-semiconductor-manufacturing-building-talent-pipeline

[23] M. L. Gray eta S. Suri, Ghost work: how to stop Silicon Valley from building a new global underclass. 2019.

[24] D. Gershgorn, “The data that transformed AI research—and possibly the world”. Online: https://qz.com/1034972/the-data-that-changed-the-direction-of-ai-research-and-possibly-the-world

[25] B. Perrigo, “OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic”. Online: https://time.com/6247678/openai-chatgpt-kenya-workers/

[26] T. Eloundou, S. Manning, P. Mishkin, eta D. Rock, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models”. arXiv, 2023ko abuztuaren 21a. Data honetan kontsultatua: 2023ko azaroaren 15a. Online: http://arxiv.org/abs/2303.10130

[27] A. Benanav, Automation and the Future of Work. 2020.

[28] D. Graeber, Bullshit Jobs: A Theory. 2018.

[29] Future of Life Institute, “Pause Giant AI Experiments: An Open Letter”, 2023ko martxoaren 22a. Online: https://futureoflife.org/open-letter/pause-giant-ai-experiments/

[30] Mozilla Foundation, “Mozilla Joins Philanthropic Coalition, Vice President Harris to Support Public Interest AI”. Online: https://foundation.mozilla.org/en/blog/mozilla-joins-philanthropic-coalition-vice-president-harris-to-support-public-interest-ai/

pursuit-semiconductor-independence[19] Q. Liu, “China’s biggest chipmaker warns geopolitics is stoking global glut”. [En línea]. Disponible en: https://www.ft.com/content/30e61fb3-ac48-4ece-94fb-af0c3763d99c

[20] Reuters, “China’s semiconductor state fund invests $2 billion in memory chip firm”. [En línea]. Disponible en: https://www.reuters.com/technology/chinas-semiconductor-state-fund-invests-2-billion-memory-chip-firm-2023-10-31/

[21] D. Shepardson, “US reports big interest in $52 billion semiconductor chips funding”. [En línea]. Disponible en: https://www.reuters.com/technology/us-reports-big-interest-52-billion-semiconductor-chips-funding-2023-08-09

[22] S. Van Sloun, “U.S. Investment in Semiconductor Manufacturing: Building the Talent Pipeline”. [En línea]. Disponible en: https://www.cfr.org/blog/us-investment-semiconductor-manufacturing-building-talent-pipeline

[23] M. L. Gray y S. Suri, Ghost work: how to stop Silicon Valley from building a new global underclass. 2019.

[24] D. Gershgorn, “The data that transformed AI research—and possibly the world”. [En línea]. Disponible en: https://qz.com/1034972/the-data-that-changed-the-direction-of-ai-research-and-possibly-the-world

[25] B. Perrigo, “OpenAI Used Kenyan Workers on Less Than $2 Per Hour to Make ChatGPT Less Toxic”. [En línea]. Disponible en: https://time.com/6247678/openai-chatgpt-kenya-workers/

[26] T. Eloundou, S. Manning, P. Mishkin, y D. Rock, “GPTs are GPTs: An Early Look at the Labor Market Impact Potential of Large Language Models”. arXiv, 21 de agosto de 2023. Accedido: 15 de noviembre de 2023. [En línea]. Disponible en: http://arxiv.org/abs/2303.10130

[27] A. Benanav, Automation and the Future of Work. 2020.

[28] D. Graeber, Bullshit Jobs: A Theory. 2018.

[29] Future of Life Institute, “Pause Giant AI Experiments: An Open Letter”, 22 de marzo de 2023. [En línea]. Disponible en: https://futureoflife.org/open-letter/pause-giant-ai-experiments/

[30] Mozilla Foundation, “Mozilla Joins Philanthropic Coalition, Vice President Harris to Support Public Interest AI”. [En línea]. Disponible en: https://foundation.mozilla.org/en/blog/mozilla-joins-philanthropic-coalition-vice-president-harris-to-support-public-interest-ai/